最近、「AIに論文を書かせてもいいの?」「ChatGPTで英語論文を書いても問題ない?」という質問が急増しています。

しかし最初に強調したいことがあります。

【重要】AI任せの論文は“完全にNG”です

ChatGPTやAIツールは強力ですが、

- データ捏造(Hallucination)

- 引用文献の創作

- 論理の誤り

- 著者責任の所在不明

など、多数のリスクがあります。

そして、AIは著者になれません。責任を負えないからです。

学術界では今、「AIの利用はOKだが、AIに“書かせた論文”はNG」というのが世界的コンセンサスです。

では、AIは使ってはいけないのか?

いいえ、違います。

“AI任せ”がNGなだけで、研究者がコントロールする前提なら、AIは最強のサポートツールになります。

問題なのは「どう使うか」です。

この記事では、

- AI時代の論文作成の変化

- ChatGPTの具体的な活用方法

- 倫理的な注意点(←ここ重要)

- 再現性を保ちつつ使う戦略

をまとめて解説します。

AI時代の論文作成はどう変わる?|研究とAIの最新トレンド

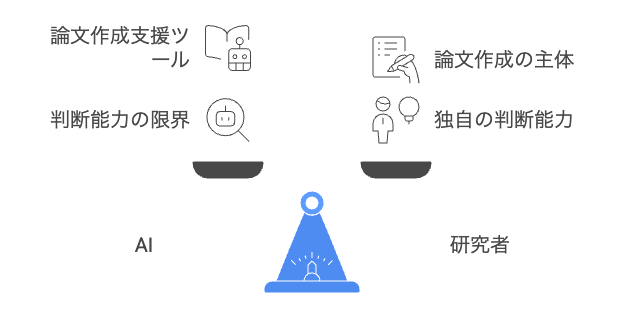

AIが急速に進化する中、多くの研究者が「AIは論文を書いてくれるのか?」「研究はAIに置き換えられてしまうのか?」という疑問を抱えています。しかし結論から言えば、AIはあなたの代わりに論文を書く存在にはなりません。

その理由はシンプルで、AIは“あなたの能力以上の判断”をしてくれないからです。

AIは「能力を上乗せする魔法のツール」ではない

AIがいくら優れていても、それは あなたの専門知識・論理的思考・批判的判断の“範囲内”でしか使えない ということです。

たとえばChatGPTが分析モデルを提案したとします。それが妥当かどうかを判断するのは誰でしょうか?

もちろん 研究者であるあなた自身 です。

AIが出す答えは「正解ではなく、単なる“可能性”」

ChatGPTは次のような性質を持っています:

- “もっともらしい文章”を生成する

- しかし間違っていても自信満々

- 存在しない文献を作ることがある

- 統計モデルの誤適用を平気で行う

つまり、AIの回答が正しいかどうかは人間が判断する必要があるのです。

この「判断」ができなければ、AIは“役に立つどころか危険”になります。

なぜ、AIはあなたの能力以上には機能しないのか?

理由は3つあります。

① AIは“真偽”を判断していない

ChatGPTは「最もらしさ」で文章を生成しているだけで、

- この仮説は妥当か

- この解析手法は適切か

- この結論はデータに支えられているか

を判断しているわけではありません。判断しているのはあなたです。

② AIのミスを見抜けるのは、あなたの専門知識だけ

AIが間違った統計解析を提案しても、

- どこが違うのか

- なぜ誤りなのか

- どう修正すべきか

に気づけるのはあなたの知識があるからです。

逆に言えば、知識がない部分をAIに丸投げすると、誤った研究が完成する危険性があります。

③ AIは“あなたの期待する正解”を推測するだけ

ChatGPTは「質問した人が何を望んでいるか」を推測するモデルです。

つまり、あなたが誤った前提で質問すれば、誤った方向に“もっともらしい回答”を作り上げてしまう。

これは研究において非常に危険です。

AIの正しい位置づけ:能力を拡張するのではなく“時間を削減する”ツール

ではAIは使うべきではないのか?そんなことはありません。むしろ、正しく使えば劇的にあなたの生産性を高めます。

AIが本領を発揮するのは、“あなた自身が理解している領域で、時間がかかっていた作業” です。

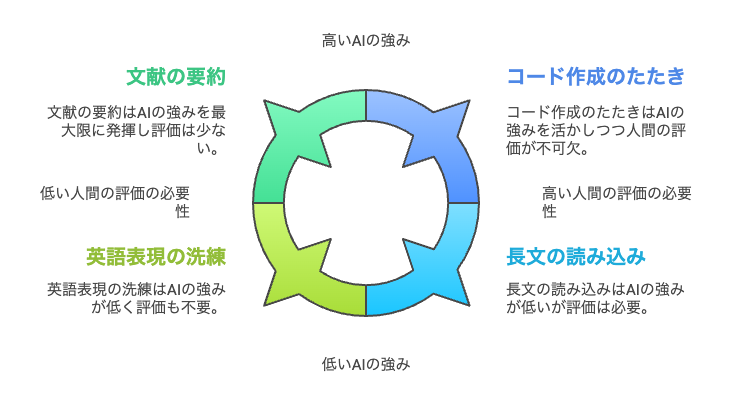

AIが最も強く機能する場面

- 文献の要点をまとめさせる

- 文章の構造を整理させる

- 英語表現を洗練させる

- 長文の読み込みを手助けしてもらう

- 曖昧な説明をわかりやすく書き換える

- コード作成のたたきを作ってもらう

これはすべて、人間が理解している前提でこそ、正しく評価できる作業です。

AIは「あなたの能力を補完する相棒」

AIは研究を“高速化”するツールであって、あなたの専門性を置き換えるものではありません。むしろ、

- あなたの思考速度を上げ

- あなたの時間を節約し

- あなたの文章を洗練させ

- あなたの理解を深める

という方向でこそ、最大限の力を発揮します。

AIを使う研究者が最強になる

AIを怖がる必要はありません。大事なのは「正しく使うこと」。

- AI任せの論文は倫理的にNG

- AIはあなたの能力を超えない

- AIはあなたの判断力があって初めて機能する

だからこそ、AIを理解した研究者こそ最強です。

今後の研究者に求められるスキルは、 “AIに仕事を任せる力”ではなく、“AIを評価し、正しく使う力” です。

ChatGPTで論文を書く・要約する・校正する|具体的な使い方

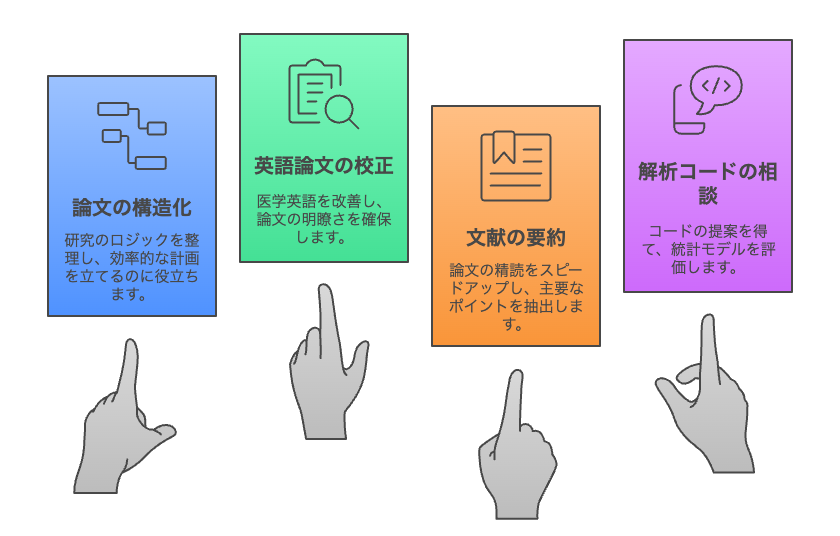

ChatGPTに論文そのものを書かせるのはNG。ただし構造化は最強。

論文を“丸ごと書かせる”ことは研究倫理的にアウトです。

しかし、構造を整理するためのサポートとして使うのは非常に有効です。

① ChatGPTで論文の構造(IMRAD)を設計する

「糖尿病患者における○○の研究」でIMRAD構造を作ってください。

研究目的・仮説・使用変数・先行研究のギャップを整理して。

ChatGPTはロジックを瞬時に構造化します。

② ChatGPTで英語論文の校正(Editing)

AIは“執筆”より“校正”に強い。

以下の英文を医学英語として自然な論文調に書き直してください。

語調はneutralで、過度に装飾的にしないでください。

校正の補助として使うのは倫理上問題ありません。(多くの大学・ジャーナルが容認)

③ ChatGPTで文献の要約

文献をPDFで入力し、要点整理を依頼できます。

この論文のBackground/Methods/Resultsを300字ずつでまとめて。

研究の限界も抽出してください。

論文精読が劇的に早くなります。

④ ChatGPTで解析コードの相談(R/Python)

ChatGPTは“コードを書く力”が非常に高いです。

ただし、出てきたコードをそのまま信じてはいけません。

エラーも出すし、間違った統計モデルを推奨することすらあります。あくまで相談相手として使うのが正解。

AI利用はここが危険|研究倫理とリスク

ChatGPTをはじめとする生成AIは、研究者にとって強力なツールですが、使い方を誤ると研究倫理に反するだけでなく、学術的不正に直結する危険があります。

特に論文作成においては、「便利だから使う」よりも「リスクを理解したうえで使う」ことが重要です。

以下では、研究者が必ず押さえておくべきAI利用のリスクと、その理由を深堀りして解説します。

① AIは“もっともらしい嘘”を平気で作る(Hallucination)

AIには、

- 存在しない文献を捏造する

- 出典不明の研究結果を“事実”として書く

- 統計解析の結果を勝手に補完する

- 方法論を論理的に破綻した形で提案する

という特性があります。

これはChatGPTの問題ではなく、生成AIの構造的な限界です。

AIは「最もらしさ」で回答を作るため、事実確認をしていません。

つまり、AIのアウトプットは正解ではなく、“それっぽい文章”でしかない のです。

研究においてこれは致命的です。

② AIは透明性がなく、再現性を保証できない

研究の核心は「再現性」です。しかしAIは、

- どのデータを参照したのか

- なぜその結論になったのか

- 他の研究と矛盾しないか

を説明できません。

これは “ブラックボックス” であり、人間が責任を持って判断できる範囲を超えています。

AIが生成した分析結果や解釈をそのまま論文に使うと、研究の再現性が担保できず、不正扱いされるリスクすらある のです。

③ AIは著者(Author)になれない

ICMJE(国際医学雑誌編集者会議)は明言しています。

AIは著者として認められない。なぜなら、説明責任・利益相反・オリジナリティに関する責任を負えないから。

著者として認められるためには、

- 解釈に責任を持つ

- 批判的判断を行う

- 書かれた内容の正確性を担保できる

必要があります。AIはこれらを満たせません。

つまり、 “AIが書いた文章にあなたが名前を載せる”のは不正です。 (あなたが責任を負えないため)

④ AIには「理解」がなく、科学的判断ができない

AIは文章を理解しているように見えますが、実際には「パターン予測」をしているだけです。

- 因果と相関の違い

- 統計モデルの前提

- 臨床的意義

- サンプルサイズの妥当性

- 研究デザインの適切性

これらを判断できるのは“人間だけ”。AIはあなたの専門知識を超えた判断を絶対にできません。

AIは賢く見えるだけで、「科学的判断力はゼロ」である。

これを理解せずにAIを使うのは非常に危険です。

⑤ AIの提案は“バグだらけの補助輪”であると理解すべき

ChatGPTにコードを書かせたり、解析モデルを聞いたりすると、一見正しそうな回答が得られます。

しかし実際には、

- 誤った統計モデル

- 存在しない関数

- 方針と矛盾した解析

など、多くの“バグ”が混じります。

AIの出力を盲信する研究者が増えると、不正論文・誤った研究結果が増える懸念があり、学会もこれを強く警戒しています。

⑥ AI利用の明記は「義務」になりつつある

多くの学会誌はAI使用ポリシーを公開しています。

共通するのは以下の4点。

- AIは著者として記載不可

- AIが生成した文章は“そのまま”使用不可

- AIの利用はMethodsまたは謝辞で開示する

- 責任はすべて人間の著者にある

つまり、AIの利用は“隠すものではなく開示するもの”になりつつあります。

⑦ AI利用でもっとも危険なのは「能力以上の依存」

あなたの論文の質を決めるのは、あなたの専門知識 × あなたの判断力であり、AIはその“効率化”にすぎません。

逆に言えば、

- 自分で理解できない領域

- 自分で評価できない内容

- 自分で確認できない分析

をAIに任せると、あなたの能力を超えて誤りが広がるという危険な構図になります。

AIは“能力を拡張するツール”ではなく、あなたの能力の範囲内で、作業時間を劇的に減らすツールです。

結論:AIは“最高の助手”、しかし“最悪の代筆者”

- AIは時間を節約し、文章を整え、分析を補助する優秀な助手

- しかし、AIは理解せず、責任を負わず、嘘も作る

- 研究倫理の観点から、AI任せの論文は絶対にNG

- AIをどう評価し、どう制御できるかが研究者の力量になる

AIはあなたのために働く存在であって、あなたの代わりに論文を書く存在ではない。

この姿勢さえあれば、AIはあなたの研究力を“安全に”最大化する強力な相棒になります。

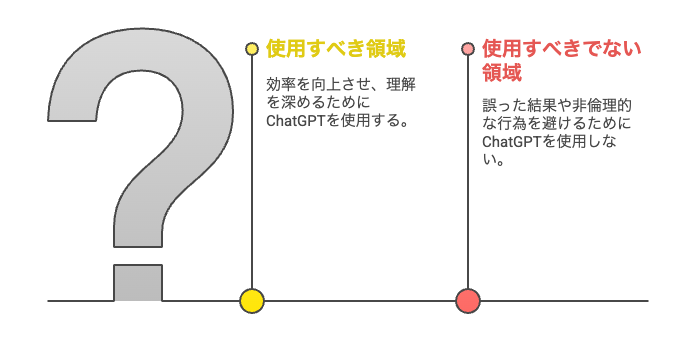

ChatGPTを使うべき領域/使うべきでない領域

ChatGPTは論文作成を強力にサポートしてくれるツールですが、「どこまで使ってよいか」の線引きがとても重要です。

AIには理解や判断力がないため、あなたの専門知識によって出力結果を評価できる範囲で活用する必要があります。

つまり、AIはあなたの能力を超えて仕事をすることはできません。

研究者側が批判的にチェックできる領域でこそ、AIは最大限の力を発揮します。

まず、ChatGPTを使うべき領域は「あなたが理解できる部分の時短化」です。たとえば以下のような場面です。

- 文献の要点を圧縮して理解する

- 自分が書いた文章を整理・要約させる

- 英語表現を自然な論文調に整える

- IMRAD構造の下書きを作る

- 論旨を明確にするための書き換え

- コード例の作成や、エラー原因の補助的な説明

これらは、あなたが内容を判断できる領域であり、AIが作業効率を大きく改善してくれます。

一方で、ChatGPTに任せてはいけない領域も明確です。

- 研究デザインの決定

- 統計解析の解釈や結論

- 存在しない文献の引用作成

- 論文本文の“丸ごと生成”

- 科学的根拠の判断

- 専門的な因果推論や統計モデルの妥当性判断

これらはAIが「もっともらしい嘘」を生成しやすく、研究倫理や再現性の面で重大な問題を引き起こす可能性があります。

AIを使うか迷ったときは 「自分がその出力を批判的に評価できるか?」 を基準にしてください。評価できるなら使ってOK。評価できないなら使ってはいけません。

AIは、あなたの能力を補う“相棒”にはなれても、あなたの代わりに論文を書く“研究者”にはなれません。正しい領域で使うことこそが、AI時代の研究者に求められる新しい能力です。

まとめ|AIは“論文を書く代わり”ではなく“あなたを強くする相棒”

AIに任せっきりの論文はNG。

しかし、賢く使えば、研究者の時間を大幅に節約し、論理構成を助け、英語の品質を上げてくれます。

- AIに責任を負わせることはできない

- AIは嘘をつくが、うまく使えば最強の助手

- 任せっきりでは倫理違反だが、補助に使うのは大いにOK

- AI時代の研究者は「使いこなす力」が求められる

AIは、あなたの研究の価値を最大化する“相棒”です。

上手に使って、論文作成のスピードと質を引き上げてください。

コメント